Jak działają LLM-y i do czego są wykorzystywane w firmach?

Zanim przejdziemy do omówienia LLMOps, wyjaśnijmy najpierw, czym są duże modele językowe LLM. To systemy uczenia maszynowego przeszkolone na gigantycznych zbiorach tekstów — od książek, przez artykuły internetowe, po kody źródłowe, ale też obrazy, a choćby materiały wideo. Dzięki temu uczą się zrozumieć gramatykę, semantykę i kontekst ludzkiego języka. Wykorzystują one architekturę transformerów opisaną po raz pierwszy w 2017 roku przez naukowców Google w artykule „Attention Is All You Need”. Mogą dzięki niej przewidywać kolejne słowa w zdaniu, tworząc w ten sposób płynne i naturalne wypowiedzi.

Jako uniwersalne narzędzia, LLM-y w firmach znajdują szerokie zastosowanie, między innymi do:

- budowania wewnętrznych wektorowych baz danych do sprawnego wyszukiwania istotnych informacji w oparciu o rozumienie zapytania, a nie tylko słowa najważniejsze — przykładem może być firma prawnicza, która wykorzystuje LLM do tworzenia wektorowej bazy danych wszystkich istotnych przepisów i orzeczeń sądowych. Pozwala to na szybkie wyszukiwanie informacji kluczowych dla danej sprawy;

- automatyzacji procesów CI/CD (Continuous Integration/Continuous Deployment) poprzez generowanie skryptów i dokumentacji — duże firmy technologiczne mogą wykorzystywać LLM-y do automatycznego generowania kodu, testów jednostkowych i dokumentowania nowych funkcji oprogramowania, przyspieszając cykle wydawnicze;

- zbierania, przygotowywania i oznaczania danych — LLM może pomagać w przetwarzaniu i kategoryzowaniu ogromnych ilości danych tekstowych, obrazowych lub dźwiękowych, co jest niezbędne do trenowania innych modeli uczenia maszynowego.

Firmy mogą także dopasowywać wcześniej przeszkolone LLM-y do swoich branż, ucząc je języka specjalistycznego i kontekstu biznesowego (fine-tuning).

Najczęściej jednak wykorzystywanie możliwości LLM-ów w firmach polega na generowaniu treści, tłumaczeniu języków i tworzeniu kodu. LLM-y potrafią bowiem tworzyć spójne opisy produktów, raporty biznesowe, a choćby pomagać programistom w pisaniu kodu źródłowego w różnych językach programowania.

Mimo ogromnego potencjału LLM-ów, firmy muszą mieć świadomość towarzyszących im wyzwań i ograniczeń. Obejmują one koszty obliczeniowe, ryzyko uprzedzeń w danych treningowych, potrzebę regularnego monitorowania i dostrajania modeli oraz wyzwania związane z bezpieczeństwem i prywatnością. Należy też pamiętać, iż rezultaty generowane przez modele na obecnym etapie rozwoju wymagają ludzkiego nadzoru z powodu pojawiających się w nich błędów (halucynacji).

Źródło: DALL·E 3, prompt: Marta M. Kania (https://www.linkedin.com/in/martamatyldakania/)

Czym jest LLMOps?

LLMOps, czyli Large Language Model Operations to zestaw praktyk służących do efektywnego wdrażania i zarządzania dużymi modelami języka naturalnego (LLM) w środowisku produkcyjnym. Dzięki LLMOps modele AI mogą gwałtownie i skutecznie odpowiadać na pytania, dostarczać podsumowań i wykonywać skomplikowane instrukcje, co przekłada się na lepsze doświadczenia użytkowników i większą wartość biznesową. LLMOps odnosi się zatem do zbioru praktyk, procedur i przepływów pracy ułatwiających rozwój, wdrażanie i zarządzanie dużymi modelami językowymi przez cały cykl ich życia.

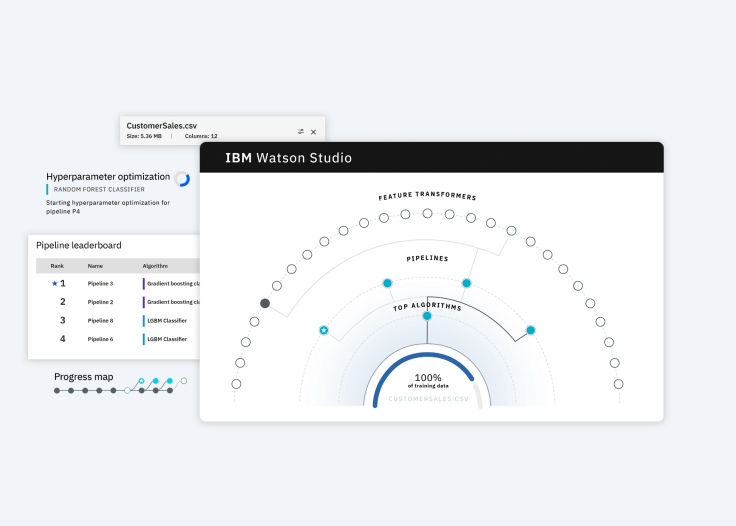

Można je postrzegać jako rozszerzenie koncepcji MLOps (Machine Learning Operations) dostosowane do specyficznych wymagań LLM-ów. Platformy LLMOps, takie jak Vertex AI od Google, Databricks Data Intelligence Platform czy IBM Watson Studio umożliwiają efektywniejsze zarządzanie bibliotekami modeli, obniżając koszty operacyjne i pozwalając mniej technicznym pracownikom na wykonywanie zadań związanych z LLM-ami.

W przeciwieństwie do tradycyjnych operacji software’owych LLMOps muszą radzić sobie ze złożonymi wyzwaniami, takimi jak:

- przetwarzanie ogromnych ilości danych,

- trenowanie modeli wymagających dużej mocy obliczeniowej,

- wdrażanie LLM-ów w firmie,

- ich monitorowanie i dostrajanie,

- zapewnienie bezpieczeństwa i prywatności wrażliwych informacji.

LLMOps nabiera szczególnego znaczenia w obecnym krajobrazie biznesowym, w którym firmy coraz częściej polegają na zaawansowanych i gwałtownie rozwijających się rozwiązaniach AI. Standaryzacja i automatyzacja procesów związanych z tymi modelami pozwala organizacjom na sprawniejsze wdrażanie innowacji opartych na przetwarzaniu języka naturalnego.

Źródło: IBM Watson Studio (https://www.ibm.com/products/watson-studio)

MLOps a LLMOps — różnice i podobieństwa

Chociaż LLMOps wyrosły z dobrych praktyk MLOps, to wymagają odmiennego podejścia ze względu na specyfikę dużych modeli językowych. Zrozumienie tych różnic jest najważniejsze dla firm, które chcą efektywnie wdrażać LLM-y.

Podobnie jak w przypadku MLOps, LLMOps opiera się na współpracy Data Scientists zajmujących się danymi, inżynierów DevOps i specjalistów IT. W przypadku LLMOps większy nacisk kładzie się jednak na:

- metryki oceny wydajności, takie jak BLEU (mierząca jakość tłumaczeń) i ROUGE (oceniająca podsumowania tekstów), zamiast klasycznych metryk uczenia maszynowego;

- jakość prompt engineeringu — czyli opracowywanie odpowiednich zapytań i kontekstów, aby uzyskać pożądane wyniki od LLM-ów;

- ciągłą informację zwrotną od użytkowników — wykorzystanie ocen do iteracyjnego doskonalenia modeli;

- większy nacisk na testowanie jakościowe przez ludzi podczas ciągłego wdrażania;

- obsługę wektorowych baz danych.

Pomimo tych różnic, MLOps i LLMOps mają wspólny cel — zautomatyzowanie powtarzalnych zadań oraz promowanie ciągłej integracji i wdrażania w celu zwiększenia wydajności. najważniejsze jest więc zrozumienie unikalnych wyzwań LLMOps i dostosowanie strategii do specyfiki dużych modeli językowych.

Kluczowe zasady LLMOps

Skuteczne wdrożenie LLMOps wymaga przestrzegania kilku kluczowych zasad. Ich stosowanie zapewni efektywne i bezpieczne wykorzystanie potencjału LLMów w organizacji. Poniższych 11 zasad LLMOps dotyczy zarówno tworzenia, optymalizacji działania, jak i monitorowania działania LLM-ów w organizacji.

- Zarządzanie zasobami obliczeniowymi. Procesy LLM-ów, takie jak trenowanie, wymagają dużej mocy obliczeniowej, dlatego korzystanie z wyspecjalizowanych procesorów, takich jak karty GPU (Graphics Processing Unit), NPU (Neural Network Processing Unit) czy TPU (Tensor Processing Unit) pozwala znacznie przyspieszyć te operacje i obniżyć koszty. Należy monitorować i optymalizować wykorzystanie zasobów w celu uzyskania maksymalnej wydajności.

- Ciągłe monitorowanie i konserwacja modeli. Narzędzia monitorujące mogą wykrywać spadki wydajności modelu w czasie rzeczywistym, umożliwiając szybką reakcję. Zbieranie informacji zwrotnej od użytkowników i ekspertów umożliwia iteracyjne dopracowywanie modelu, co zapewnia jego długotrwałą skuteczność.

- Odpowiednie zarządzanie danymi. Wybór systemu pozwalającego na efektywne przechowywanie i odzyskiwanie dużych ilości danych w całym cyklu życia LLM-ów jest kluczowe. Automatyzacja procesów zbierania, czyszczenia i przetwarzania danych zapewni stały dopływ wysokiej jakości informacji do trenowania modeli.

- Przygotowanie danych. Regularne przekształcanie, agregowanie i oddzielanie danych jest niezbędne, aby zapewnić ich odpowiednią jakość. Dane powinny być widoczne i możliwe do udostępniania między zespołami, co ułatwi współpracę i zwiększy efektywność.

- Inżynieria promptów. Prompt engineering polega na wydawaniu LLM-owi jasnych komend wyrażonych w języku naturalnym. Trafność i powtarzalność odpowiedzi udzielanych przez modele językowe, a także adekwatne i zgodne z oczekiwaniami korzystanie z kontekstu zależą w dużej mierze od precyzji promptów.

- Wdrażanie. Aby zoptymalizować koszty, należy dostosować wcześniej wytrenowane modele do konkretnych zadań i środowisk. Platformy takie jak NVIDIA TensorRT czy ONNX Runtime oferują narzędzia do optymalizacji uczenia głębokiego, co pozwala zmniejszyć rozmiar modeli i przyspieszyć ich działanie.

- Odzyskiwanie po awarii. Regularne tworzenie kopii zapasowych modeli, danych i konfiguracji pozwala na zachowanie ciągłości działania w przypadku awarii systemu. Wdrożenie mechanizmów redundancji, takich jak replikacja danych i równoważenie obciążenia, zwiększa niezawodność całego rozwiązania.

- Etyczne tworzenie modeli. Należy przewidywać, wykrywać i korygować w danych treningowych i wynikach modeli wszelkie uprzedzenia, które mogą zniekształcać wyniki i prowadzić do nieuczciwych lub szkodliwych decyzji. Firmy powinny wdrożyć procesy zapewniające odpowiedzialny i etyczny rozwój systemów LLM.

- Informacje zwrotne od ludzi. Wzmacnianie modelu poprzez informacje zwrotne od użytkowników (RLHF – Reinforcement Learning from Human Feedback) może znacząco poprawić jego wydajność, ponieważ zadania LLM-ów często mają otwarty charakter. Ludzka ocena pozwala na dostrojenie modelu do preferowanych zachowań.

- Łańcuchy i potoki LLM-ów. Narzędzia takie jak LangChain i LlamaIndex umożliwiają łączenie wielu wywołań LLM-ów i interakcję z zewnętrznymi systemami w celu realizacji złożonych zadań. Pozwala to na budowę kompleksowych aplikacji opartych na LLM-ach.

- Strojenie modeli. Biblioteki open source, takie jak Hugging Face Transformers, PyTorch, lub TensorFlow, pomagają w poprawie wydajności modeli poprzez optymalizację algorytmów uczenia i wykorzystania zasobów. najważniejsze jest również zmniejszanie opóźnień modelu, aby zapewnić responsywność aplikacji.

Źródło: Tensor Flow (https://blog.tensorflow.org/2024/03/whats-new-in-tensorflow-216.html?hl=pl)

Podsumowanie

LLMOps umożliwiają firmom bezpieczne i niezawodne wdrażanie zaawansowanych modeli językowych, a zarazem definiują sposób, w jaki organizacje wykorzystują technologie przetwarzania języka naturalnego. Poprzez automatyzowanie procesów, ciągłe monitorowanie i dostosowywanie do specyficznych potrzeb biznesowych organizacje mogą w pełni wykorzystać ogromny potencjał LLM-ów w generowaniu treści, automatyzacji zadań, analizie danych i wielu innych obszarach.

Choć LLMOps wyrosły z dobrych praktyk MLOps, to wymagają odmiennych narzędzi i strategii dostosowanych do wyzwań związanych z zarządzaniem dużymi modelami językowymi. Tylko dzięki przemyślanemu i spójnemu podejściu firmy będą w stanie efektywnie wykorzystywać tę przełomową technologię, zapewniając jednocześnie bezpieczeństwo, skalowalność i zgodność z przepisami.

W miarę jak LLM-y stają się coraz bardziej zaawansowane, rola LLMOps rośnie, dając organizacjom solidne podstawy do wdrażania tych potężnych systemów AI w sposób kontrolowany i zrównoważony. Firmy, które zainwestują w rozwój kompetencji w zakresie LLMOps, będą miały strategiczną przewagę w wykorzystywaniu innowacji opartych na przetwarzaniu języka naturalnego, co pozwoli im pozostać na czele transformacji cyfrowej.

1 rok temu

1 rok temu