Czym jest ReALM?

ReALM to skrót od „Reference Resolution As Language Modeling” – przełomowe rozwiązanie opracowane przez naukowców z Apple. Jest to zatem nowy model językowy (Large Language Model, LLM), który traktuje problem rozpoznawania odniesień jako zadanie z dziedziny modelowania języka.

ReALM efektywnie konwertuje różne rodzaje kontekstu na reprezentację tekstową, którą następnie przetwarza w ramach zadania językowego. Mogą to być:

- konwersacje – na przykład SMS-y, polecenia głosowe kierowane do asystenta czy maile,

- elementy na ekranie – na przykład zdjęcia, kalendarz, widget pogodowy, czy działające w tle aplikacje i procesy.

Czym ReALM różni się od innych modeli rozpoznawania odniesień? Przede wszystkim podejściem – zamiast polegać na przetwarzaniu obrazów, ReALM działa w domenie tekstowej. To sprawia, iż jest znacznie lżejszy i wydajniejszy, co ma umożliwiać uruchamianie go bezpośrednio w urządzeniach mobilnych przy zachowaniu prywatności użytkownika.

W czym ReALM jest lepszy od GPT-4?

Zespół badawczy Apple porównał ReALM z najpotężniejszymi modelami językowymi dostępnymi w tej chwili na rynku – GPT-3.5 i GPT-4 od OpenAI. Wyniki są naprawdę imponujące. W zadaniach rozpoznawania odniesień najmniejszy wariant ReALM osiągał dokładność porównywalną z GPT-4! Większe modele ReALM przewyższały GPT-4 już w rozpoznawaniu odniesień do elementów wyświetlanych na ekranie.

Czym tłumaczyć tę przewagę? Po pierwsze, ReALM radzi sobie znakomicie z zapytaniami specyficznymi dla danej dziedziny, na przykład dotyczącymi urządzeń domowych typu smart. To zasługa fine-tuningu modelu na danych z konkretnej dziedziny, który sprawia, iż ReALM wykazuje głębsze zrozumienie kontekstu.

Co więcej, w przeciwieństwie do GPT-4 trenowanego głównie na zdjęciach przedstawiających obiekty rzeczywiste, ReALM doskonale radzi sobie z rozpoznawaniem elementów tekstowych i składowych interfejsów użytkownika aplikacji. A to właśnie rozumienie interfejsów jest najważniejsze dla płynnej interakcji asystentów głosowych z aplikacjami, z których właśnie korzystamy.

Źródło: DALL·E 3, prompt: Marta M. Kania (https://www.linkedin.com/in/martamatyldakania/)

Czy to początek ery naprawdę inteligentnych asystentów?

Integracja ReALM z Siri może rzeczywiście otworzyć zupełnie nowy rozdział w interakcjach człowiek–komputer. Dzięki ReALM Siri będzie w stanie zrozumieć polecenia zawierające odniesienia do elementów wyświetlanych na ekranie telefona oraz procesy i aplikacje działające w tle. Kiedy jednak ta opcja będzie dostępna dla użytkowników? Tego jeszcze nie wiadomo.

Pozostają nam spekulacje bazujące na technicznych możliwościach modelu. Jak zatem może działać Siri wyposażona w ReALM? Na przykład: kiedy przeglądasz stronę internetową z ofertami biznesowymi i widzisz interesującą Cię firmę, wystarczy, iż powiesz do Siri „Zadzwoń do tej firmy”, a asystent – wykorzystując ReALM do przeanalizowania kontekstu – odnajdzie numer telefonu wskazanej firmy i zainicjuje połączenie. Nie będzie to choćby wymagało od Ciebie wyjaśniania, o którą firmę dokładnie Ci chodzi.

A to dopiero początek możliwości ReALM. Polecenia takie jak „Odtwórz ostatnią playlistę” pozwoliłyby na intuicyjną kontrolę aplikacji multimedialnych i urządzeń inteligentnego domu. ReALM mógłby też umożliwić Siri rozumienie kontekstu rozmów i historii poleceń, aby asystent reagował adekwatnie do wcześniejszych żądań użytkownika. To krok w stronę inteligentnych agentów przybliżający nas nie tyle do sztucznej inteligencji rozumiejącej nasze zapytania, ile do takiej, która będzie umiała realizować polecenia.

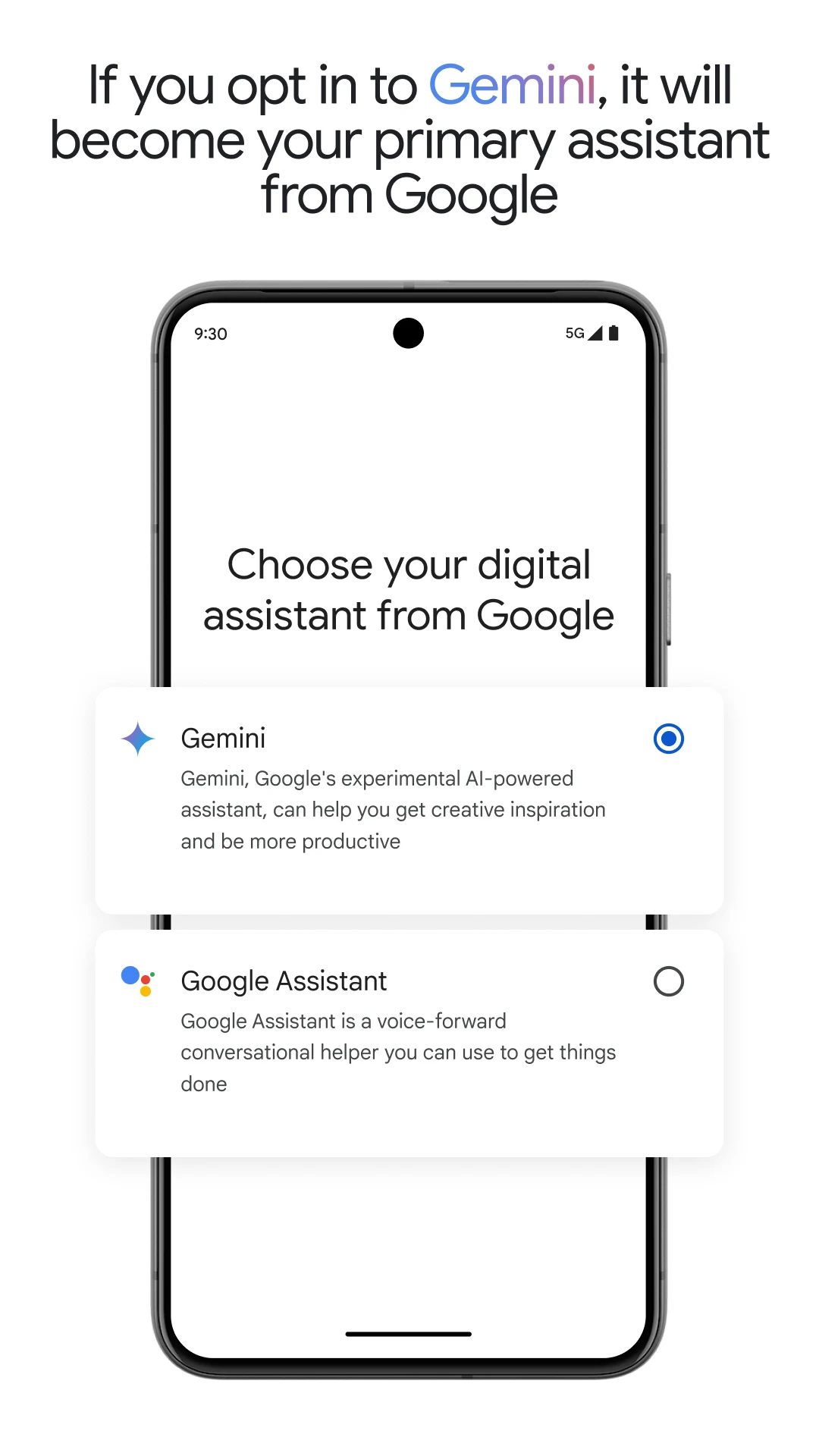

Niestety użytkownicy urządzeń z systemem Android muszą jeszcze poczekać. Na razie nie ma informacji na temat planów Google względem wyposażenia Google Assistant w możliwości modeli językowych z rodziny Gemini. Powstała aplikacja Google Gemini na urządzenia z Androidem, jednak nie pozostało dostępna poza Stanami Zjednoczonymi.

Źródło: Google Play (https://play.google.com/store/apps/details?id=com.google.android.apps.bard&hl=en_US)

Podsumowanie

ReALM to innowacyjne podejście Apple do rozwiązania problemu rozpoznawania kontekstu przez asystentów głosowych. Zamiast polegać na przetwarzaniu obrazów, ten model językowy konwertuje różne rodzaje kontekstu na reprezentację tekstową, którą następnie przetwarza w ramach zadania językowego. Takie podejście zapewnia nie tylko wysoką dokładność rozpoznawania, ale też możliwość działania na urządzeniu mobilnym przy zachowaniu prywatności użytkownika.

Umożliwienie Siri dostępu do ReALM może zapewnić bardziej naturalne i kontekstowe interakcje głosowe, stanowiąc istotny krok w kierunku naprawdę inteligentnych asystentów. Dzięki ReALM Siri będzie w stanie błyskawicznie reagować na polecenia zawierające odniesienia do elementów na ekranie, aplikacji i procesów działających w tle. Jedno jest pewne – doskonalenie kontekstowej świadomości asystentów to klucz do stworzenia naprawdę inteligentnej i naturalnej interakcji głosowej, a ReALM jest niewątpliwie ważnym krokiem w tym kierunku.

1 rok temu

1 rok temu

![Wdowy po działaczach opozycji antykomunistycznej z dodatkowymi pieniędzmi [PROJEKT]](https://g.infor.pl/p/_files/38744000/wdowa-seniorka-38744493.jpg)

![Policja zatrzymała 50 -letniego mężczyznę. Od miesięcy znęcał się nad żoną. Bił, kopał i poniżał [WIDEO]](https://storage.googleapis.com/poludniowaoficyna-pbem/zpleszewa/articles/image/bc652bee-eb06-4adf-b807-dfdc87b170ab)